Responsabilités éditoriales : Direction de la collection "Droit et Economie", L.G.D.J. - Lextenso éditions (29)

🌐suivre Marie-Anne Frison-Roche sur LinkedIn

🌐souscrire à la Newsletter MAFR. Regulation, Compliance, Law

____

► Référence complète : M.-A. Frison-Roche (dir.), Contentieux Systémique Émergent, LGDJ, coll. "Droit & Économie", à paraître

____

📚Consulter tous les autres titres de la collection dans laquelle cet ouvrage est publié

____

► Présentation générale de l'ouvrage :

____

TABLE DES MATIÈRES

Vision d’ensemble ♦️ L’Émergence du Contentieux Systémique, par 🕴️Marie-Anne Frison-Roche, professeure de Droit de la Régulation et de la Compliance, directrice du Journal of Regulation & Compliance (JoRC)

PREMIÈRE PARTIE

CONTENTIEUX SYSTÉMIQUE ÉMERGENT : DÉFINITION ET EXPÉRIENCES

Chapitre 1 ♦️ L’unicité du Contentieux Systémique Émergent, par 🕴️Marie-Anne Frison-Roche, professeure de Droit de la Régulation et de la Compliance, directrice du Journal of Regulation & Compliance (JoRC)

Chapitre 2 ♦️ L’office du magistrat du parquet dans les contentieux systémiques, par 🕴️François Vaissette, Avocat général près la Cour d’appel de Paris

Chapitre 3 ♦️ sss, par 🕴️ Benjamin Deparis, sss

Chapitre 5 ♦️ sss, par 🕴️ Jean-François Beynel, sss

Chapitre 6 ♦️ L’appréhension par la cour d’appel de Paris du contentieux systémique émergent, par 🕴️Brigitte Brun-Lallemand, Première Présidente de Chambre à la Cour d’appel de Paris, Coordinatrice du Pôle 5 Économique et commercial

Chapitre 7 ♦️ sssss, par 🕴️ Sandrine Zientara, ssss

Chapitre 8 ♦️ Contentieux systémique et émergent. Le point de vue du Tribunal de l’Union européenne, par 🕴️ Marc van der Woude, Président du Tribunal de l’Union européenne

Chapitre 9 ♦️ sss, par 🕴️Jacques Boulard, Premier Président de la Cour d’appel de Paris

DEUXIÈME PARTIE

LA VIGILANCE, POINTE AVANCÉE DU CONTENTIEUX SYSTÉMIQUE ÉMERGENT

Chapitre 1 ♦️ En quoi le contentieux systémique de la vigilance est nouveau, par 🕴️Marie-Anne Frison-Roche, professeure de Droit de la Régulation et de la Compliance, directrice du Journal of Regulation & Compliance (JoRC)

Chapitre 2 ♦️ Choix et embranchements de compétences lorsqu'un enjeu de vigilance est allégué, par 🕴️Marie-Anne Frison-Roche, professeure de Droit de la Régulation et de la Compliance, directrice du Journal of Regulation & Compliance (JoRC)

Chapitre 3 ♦️ L’aptitude du Code de procédure civile à permettre le traitement efficace et adapté des systémiques de vigilance (action en justice, mise en état, office du juge), par 🕴️Natalie Fricero, Professeure à l’Université Côte d’Azur

Chapitre 4 ♦️ Le contentieux émergent de la Vigilance dans les rapports contractuels, par🕴️Jean-Christophe Roda, Professeur à l’Université Jean-Moulin Lyon 3

Chapitre 5 ♦️ Implications des normes internationales de l’OIT dans le contentieux émergent de la vigilance dans les relations de travail, par 🕴️Cyril Cosme, Directeur du Bureau de l'OIT pour la France

Chapitre 6 ♦️ L’adéquation de la publicité des débats avec le contentieux systémique émergent, par 🕴️Marie-Anne Frison-Roche, professeure de Droit de la Régulation et de la Compliance, directrice du Journal of Regulation & Compliance (JoRC)

TROISIÈME PARTIE

LE NUMÉRIQUE, CREUSET DE CONTENTIEUX SYSTÉMIQUE ÉMERGENT

Chapitre 1 ♦️ Le Contentieux Systémique Émergent du fait du système numérique, par 🕴️ Marie-Anne Frison-Roche, professeure de Droit de la Régulation et de la Compliance, directrice du Journal of Regulation & Compliance (JoRC)

Chapitre 2 ♦️ Les techniques de gestion du risque systémique pesant sur la cybersecurité des plateformes, par 🕴️ Michel Séjean, Professeur de droit à l'Université Sorbonne Paris Nord

Chapitre 3 ♦️ Les obligations systémiques des opérateurs numériques à travers le Règlement sur les Services Numériques (RSN/DSA) et le rôle des régulateurs, par🕴️ Roch-Olivier Maistre, Président de chambre à la Cour des comptes, ancien Président de l’Autorité de régulation de la communication audiovisuelle et numérique (Arcom)

Chapitre 4 ♦️ Un contentieux systémique in vivo : le cas dit des sites pornographiques, par 🕴️Marie-Anne Frison-Roche, professeure de Droit de la Régulation et de la Compliance, directrice du Journal of Regulation & Compliance (JoRC)

Chapitre 5 ♦️ Les deux rencontres entre l'intelligence artificielle et le Contentieux Systémique, par 🕴️ Marie-Anne Frison-Roche, professeure de Droit de la Régulation et de la Compliance, directrice du Journal of Regulation & Compliance (JoRC)

Chapitre 6 ♦️ Les premiers contentieux systémiques observables impliquant l’intelligence artificielle, par 🕴️ Sonia Cissé, avocate associée, Linklaters Paris

Chapitre 7 ♦️ L’influence des nouveaux textes et des textes à venir sur les contentieux systémiques émergents impliquant l’intelligence artificielle, par🕴️ Emmanuel Netter, Professeur de Droit à l'Université de Strasbourg

QUATRIÈME PARTIE

LA DURABILITÉ, PRINCIPE DU CONTENTIEUX SYSTÉMIQUE ÉMERGENT

Chapitre 1 ♦️ L’émergence par le rapport de durabilité d’un contentieux systémique, par🕴️Marie-Anne Frison-Roche, professeure de Droit de la Régulation et de la Compliance, directrice du Journal of Regulation & Compliance (JoRC)

Chapitre 2 ♦️ Comment construire un rapport de durabilité ?, par 🕴️ Alexis Gazzo, Associé, Climate Change & Sustainability leader, EY France

Chapitre 3 ♦️ Le contrôle, par 🕴️ Florence Peybernès, Présidente de la Haute Autorité de l'Audit (H2A)

CINQUIÈME PARTIE

DES SPÉCIFICITÉS PROBATOIRES DU CONTENTIEUX SYSTÉMIQUE ÉMERGENT

Chapitre 1 ♦️ Le carré probatoire activé dans le contentieux systémique émergent, par🕴️Marie-Anne Frison-Roche, professeure de Droit de la Régulation et de la Compliance, directrice du Journal of Regulation & Compliance (JoRC)

Chapitre 2 ♦️ Les différentes techniques probatoires quand un système est impliqué dans un litige, par 🕴️ Thibault Goujon-Bethan, Professeur de droit à l’Université Jean-Moulin Lyon 3, directeur du Centre patrimoine et contrats, directeur de l’IEJ de Lyon

Chapitre 3 ♦️ Ce que des entreprises font et les preuves disponibles qui en résultent, par 🕴️ Nathalie Fabbe-Costes, Professeure de gestion à Aix-Marseille Université

Chapitre 4 ♦️ La trajectoire, objet de preuve, par🕴️Marie-Anne Frison-Roche, professeure de Droit de la Régulation et de la Compliance, directrice du Journal of Regulation & Compliance (JoRC)

Base Documentaire : Doctrine

► Référence complète : R. Sève, "Compliance Obligation and changes in Sovereignty and Citizenship", in M.-A. Frison-Roche (dir.), Compliance Obligation, Journal of Regulation & Compliance (JoRC) et Bruylant, coll. "Compliance & Regulation", à paraître

____

📘consulter une présentation générale de l'ouvrage, Compliance Obligation, dans lequel cet article est publié

____

► Résumé de l'article (fait par le Journal of Regulation & Compliance - JoRC) : The contribution describes "les changements de philosophie du droit que la notion de compliance peut impliquer par rapport à la représentation moderne de l’Etat assurant l’effectivité des lois issues de la volonté générale, dans le respect des libertés fondamentales qui constituent l’essence du sujet de droit." ("the changes in legal philosophy that the notion of Compliance may imply in relation to the modern representation of the State ensuring the effectiveness of laws resulting from the general will, while respecting the fundamental freedoms that constitute the essence of the subject of law").

The contributor believes that the definition of Compliance is due to authors who « jouer un rôle d’éclairage et de structuration d’un vaste ensemble d’idées et de phénomènes précédemment envisagés de manière disjointe. Pour ce qui nous occupe, c’est sûrement le cas de la théorie de la compliance, développée en France par Marie-Anne Frison-Roche dans la lignée de grands économistes (Jean-Jacques Laffont, Jean Tirole) et dont la première forme résidait dans les travaux bien connus de la Professeure sur le droit de la régulation. » ( "play a role in illuminating and structuring a vast set of ideas and phenomena previously considered in a disjointed manner. For our purposes, this is certainly the case with the theory of Compliance, developed in France by Marie-Anne Frison-Roche in the tradition of great economists (Jean-Jacques Laffont, Jean Tirole) and whose first form was in her well-known work on Regulatory Law").

Drawing on the Principles of the Law of the American Law Institute, which considers compliance to be a "set of rules, principles, controls, authorities, offices and practices designed to ensure that an organisation conforms to external and internal norms", he stresses that Compliance thus appears to be a neutral mechanism aimed at efficiency through a move towards Ex Ante. But he stresses that the novelty lies in the fact that it is aimed 'only' at future events, by 'refounding' and 'monumentalising' the matter through the notion of 'monumental goals' conceived by Marie-Anne Frison-Roche, giving rise to a new jus comune. Thus, "la compliance c’est l’idée permanente du droit appliquée à de nouveaux contextes et défis." ("Compliance is the permanent idea of Law applied to new contexts and challenges").

So it's not a question of making budget savings, but rather of continuing to apply the philosophy of the Social Contract to complex issues, particularly environmental issues.

This renews the place occupied by the Citizen, who appears not only as an individual, as in the classical Greek concept and that of Rousseau, but also through entities such as NGOs, while large companies, because they alone have the means to pursue the Compliance Monumental Goals, would be like "super-citizens", something that the digital space is beginning to experience, at the risk of the individuals themselves disappearing as a result of "surveillance capitalism". But in the same way that thinking about the Social Contract is linked to thinking about capitalism, Compliance is part of a logical historical extension, without any fundamental break: "C’est le développement et la complexité du capitalisme qui forcent à introduire dans les entités privées des mécanismes procéduraux d’essence bureaucratique, pour discipliner les salariés, contenir les critiques internes et externes, soutenir les managers en place" ("It is the development and complexity of capitalism that forces us to introduce procedural mechanisms of a bureaucratic nature into private entities, in order to discipline employees, contain internal and external criticism, and support the managers in place") by forcing them to justify remuneration, benefits, and so on.

Furthermore, in the words of the author, "Avec les buts monumentaux, - la prise en compte des effets lointains, diffus, agrégés par delà les frontières, de l’intérêt des générations futures, de tous les êtres vivants - , on passe, pour ainsi dire, à une dimension industrielle de l’éthique, que seuls de vastes systèmes de traitement de l’information permettent d’envisager effectivement." ("With the Monumental Goals - taking into account the distant, diffuse effects, aggregated across borders, the interests of future generations, of all living beings - we move, so to speak, to an industrial dimension of ethics, which only vast information processing systems can effectively envisage").

This is how we can find a division between artificial intelligence and human beings in organisations, particularly companies, or in decision-making processes.

In the same way, individual freedom does not disappear with Compliance, because it is precisely one of its monumental goals to enable individuals to make choices in a complex environment, particularly in the digital space where the democratic system is now at stake, while technical mechanisms such as early warning will revive the right to civil disobedience, invalidating the complaint of "surveillance capitalism".

The author concludes that the stakes are so high that Compliance, which has already overcome the distinctions between Private and Public Law and between national and international law, must also overcome the distinction between Information and secrecy, particularly in view of cyber-risks, which requires the State to develop and implement non-public Compliance strategies to safeguard the future.

____

🦉Cet article est accessible en texte intégral pour les personnes inscrites aux enseignements de la Professeure Marie-Anne Frison-Roche

________

Base Documentaire : Doctrine

► Référence complète : R. Sève, "L'Obligation de Compliance et les mutations de la souveraineté et de la citoyenneté", in M.-A. Frison-Roche (dir.), L'obligation de Compliance, Journal of Regulation & Compliance (JoRC) et Dalloz, coll. "Régulations & Compliance", 2024, à paraître.

____

📕lire une présentation générale de l'ouvrage, L'Obligation de Compliance, dans lequel cet article est publié

____

► Résumé de l'article (fait par le Journal of Regulation & Compliance - JoRC) : La contribution décrit "les changements de philosophie du droit que la notion de compliance peut impliquer par rapport à la représentation moderne de l’Etat assurant l’effectivité des lois issues de la volonté générale, dans le respect des libertés fondamentales qui constituent l’essence du sujet de droit.".

Le contributeur estime que la définition de la compliance tient à des auteurs qui « jouer un rôle d’éclairage et de structuration d’un vaste ensemble d’idées et de phénomènes précédemment envisagés de manière disjointe. Pour ce qui nous occupe, c’est sûrement le cas de la théorie de la compliance, développée en France par Marie-Anne Frison-Roche dans la lignée de grands économistes (Jean-Jacques Laffont, Jean Tirole) et dont la première forme résidait dans les travaux bien connus de la Professeure sur le droit de la régulation. ».

S'appuyant sur les Principles of the Law de l’American Law Institute, qui considère que la compliance est un « set of rules, principles, controls, authorities, offices and practices designed to ensure that an organisation conforms to external and internal norms», il souligne que la compliance apparaît alors un mécanisme neutre visant à l'efficacité par un passage vers l'Ex Ante. Mais il souligne que la nouveauté tient dans le fait de viser "seulement" des événements futurs, en "refondamentalisant" et en "monumentalisant" la matière par la notion de "buts monumentaux" conçue par Marie-Anne Frison-Roche, faisant apparaître un nouveau jus comune. Ainsi, "la compliance c’est l’idée permanente du droit appliquée à de nouveaux contextes et défis.".

Il ne s'agit donc pas de faire des économies budgétaires mais bien plutôt de continuer à faire vivre la philosophie du Contrat social à des enjeux complexes, notamment les enjeux environnementaux.

Cela renouvelle la place qu'y occupe le citoyen car il y apparaît non seulement comme individu, ce qui est dans la conception classique grecque et chez Rousseau, mais encore à travers des entités, notamment les ONG, tandis que les grandes entreprises, parce qu'elles ont seules les moyens de poursuivre les buts monumentaux de la compliance, seraient comme des "super-citoyens", ce dont l'espace numérique commence à développer l'expérience, au risque de disparition de l'individu lui-même par l'effet du "capitalisme de surveillance". Mais de la même façon que la pensée du Contrat social s'articule avec celle du capitalisme, la compliance se situe sans rupture fondamentale dans un prolongement historique logique : "C’est le développement et la complexité du capitalisme qui forcent à introduire dans les entités privées des mécanismes procéduraux d’essence bureaucratique, pour discipliner les salariés, contenir les critiques internes et externes, soutenir les managers en place" en les forçant à justifier les rémunérations, les avantages, etc.

En outre, selon les termes de l'auteur, "Avec les buts monumentaux, - la prise en compte des effets lointains, diffus, agrégés par delà les frontières, de l’intérêt des générations futures, de tous les êtres vivants - , on passe, pour ainsi dire, à une dimension industrielle de l’éthique, que seuls de vastes systèmes de traitement de l’information permettent d’envisager effectivement.".

C'est ainsi que l'on peut trouver une répartition entre l'intelligence artificielle et les êtres humains dans les organisations, notamment les entreprises, ou dans les processus de décisions.

De la même façon, la liberté de l'individu ne disparaît pas par la Compliance car c'est précisément et au contraire l'un de ses buts monumentaux que de rendre les individus aptes à choisir dans un environnement complexe, notamment dans l'espace numérique où le système démocratique est désormais en jeu, tandis que des mécanismes techniques, comme le lancement d'alerte, vont renaître le droit à la désobéissance civile, invalidant le grief de "capitalisme de surveillance".

L'auteur conclut que les enjeux sont si grands que la Compliance qui a déjà dépassé les distinctions entre le droit privé et le droit public, entre le droit national et le droit international, doit aussi dépasser celle entre l'information et et le secret, notamment en raison des cyber-risques, ce qui requiert de l'Etat l'élaboration et la pratique de stratégies non-publiques de Compliance pour préserver l'avenir.

________

Base Documentaire : Doctrine

► Référence complète : A. Nicollet, "Le Droit de la Compliance, clé de voute de la Régulation de l’intelligence artificielle", in in P. Bonis et L. Castex (dir.), Compliance et nouvelles régulations, Annales des Mines, coll. "Enjeux numériques", juin 2025.

____

____

► Voir la présentation d'articles publiés dans le même numéro :

- Pierre Bonis & Marie-Anne Frison-Roche,📝 Réguler le numérique ou Sisyphe heureux

- M.-A. Frison-Roche,📝 Le Droit de la compliance, voie royale pour réguler l'espace numérique

________

3 février 2026

Grandes et petites questions du Droit

19 novembre 2025

Base Documentaire : Doctrine

► Référence complète : B. Frydman, "Interprétation et numérisation", in Cahiers du Conseil constitutionnel, Les méthodes d'interprétation, nov. 2025.

____

____

📗Lire l'ensemble des contributions

________

16 octobre 2025

Base Documentaire : Doctrine

► Référence complète : W. Marx, "La fabrique de l'intelligence : du mot à la chose", in Formes de l'intelligence, Collège de France, 16 octobre 2025

____

► Voir le colloque Formes de l'intelligence, dans lequel la conférence s'insère.

____

____

►Résumé par l'auteur : "Le concept d’intelligence prend une place de plus en plus importante au fil du XIXe siècle dans la réflexion anthropologique et philosophique européenne, s’imposant contre des concurrents tels que l’esprit et l’entendement. Il concourt à une biologisation et une naturalisation de la réflexion historique (Comte). Par le biais de la théorie de l’évolution, le terme instaure une dialectique entre l’individu et le collectif (Spencer, Galton, Ribot). Il prend une dimension politique (Maurras, Benda). On assiste concurremment à des entreprises de dépersonnalisation et de formalisation du problème de l’intelligence (Taine, Binet, Valéry) qui ouvrent la voie aux théories de l’intelligence artificielle."

____

►Notes prises : Rappelant que "nommer, c'est construire le monde", l'orateur étudie le mot en tant qu'il est situé au XIXième pour viser l'entendement, à savoir "l'acte de comprendre, puis la faculté de comprendre". Par métonymie, une I.A. est une machine dotée de cette faculté, comme on disait des anges qu'ils sont des "intelligences divines". Puis l'accord entre deux personnes.

D'une façon concurrente, la "raison" exprime la pensée (qui s'oppose au coeur) et sa façon de s'exprimer. De la même façon, "l'entendement" renvoie à la compréhension.

Si l'intelligence a triomphé, c'est pour une raison grammaticale, car ce substantif appelle des relations avec des objets et des êtres. Pensant l'être humain comme un être en relations, ce mot triomphe dès l'instant qu'à partir du XVIIIième on se demande comment l'être humain peut se penser sans Dieu, mais donc en relation, par cette faculté transitive qu'est l'intelligence. Mais dès qu'elle cesse d'être exclusivement humaine, l'animal-machine pouvant être récusé, le problème de la définition se pose.

L'intelligence se pose alors comme une capacité à construire pour corriger les erreurs de perception, capacité qui peut être améliorée à travers une science de produire des grands hommes. La tendance est alors de penser "l'intelligence sociale" (l'intelligence française, etc.) sur le modèle de l'intelligence de l'individu : l'intelligence devient un objet de bataille politique.

Le XIXième puis le XXième siècles pose que la faculté que l'intelligence exprime n'est pas nécessairement la marque de l'être humain. Le XXième siècle en vit peut-être l'expérience.

________

15 octobre 2025

Base Documentaire : Doctrine

► Référence complète : C.S. Sunstein, Imperfect Oracle: What AI Can and Cannot Do, Université of Penn Press, 2025, 208 p.

____

► Résumé de l'ouvrage (fait par l'éditeur") : 'Imperfect Oracle is about the promise and limits of artificial intelligence. The promise is that in important ways AI is better than we are at making judgments. Its limits are evidenced by the fact that AI cannot always make accurate predictions—not today, not tomorrow, and not the day after, either.

Natural intelligence is a marvel, but human beings blunder because we are biased. We are biased in the sense that our judgments tend to go systematically wrong in predictable ways, like a scale that always shows people as heavier than they are, or like an archer who always misses the target to the right. Biases can lead us to buy products that do us no good or to make foolish investments. They can lead us to run unreasonable risks, and to refuse to run reasonable risks. They can shorten our lives. They can make us miserable.

Biases present one kind of problem; noise is another. People are noisy not in the sense that we are loud, though we might be, but in the sense that our judgments show unwanted variability. On Monday, we might make a very different judgment from the judgment we make on Friday. When we are sad, we might make a different judgment from the one we would make when we are happy. Bias and noise can produce exceedingly serious mistakes.

AI promises to avoid both bias and noise. For institutions that want to avoid mistakes it is now a great boon. AI will also help investors who want to make money and consumers who don’t want to buy products that they will end up hating. Still, the world is full of surprises, and AI cannot spoil those surprises because some of the most important forms of knowledge involve an appreciation of what we cannot know and why we cannot know it. Life would be a lot less fun if we could predict everything."

20 juin 2025

Base Documentaire : Doctrine

Référence complète : Haut Comité Juridique de la Place de Paris, Les impacts juridiques et réglementaires de l'Intelligence Artificielle en matière bancaire, financière et des assurances, juin 2025.

_____

28 avril 2025

Base Documentaire : Doctrine

► Référence complète : Cour de cassation, Préparer la Cour de cassation de demain. Cour de cassation et intelligence artificielle, rapport, avr. 2025, 159 p.

____

________

11 mars 2025

Conférences

🌐suivre Marie-Anne Frison-Roche sur LinkedIn

🌐s'abonner à la Newsletter MAFR Regulation, Compliance, Law

🌐s'abonner à la Newsletter en vidéo MAFR Surplomb

____

► Référence complète : M.-A. Frison-Roche, "Le juriste, requis et bien placé pour le futur", in Groupe Lamy Liaisons, Les Éclaireurs du Droit, Hôtel de l’Industrie, Place Saint Germain des Près, Paris, 11 mars 2025, 16h.

____

Cette intervention ouvre une manifestation composée de 4 ateliers dont les thèmes respectifs sont :

- Le défi de la confiance

- Le défi du risque

- Le défi de la transmission

- Le défi du leadership

____

🧮consulter le programme complet de cette manifestation

____

____

🎥regarder la courte présentation video faite après le colloque

____

📝lire le compte-rendu qu'il fût fait de l'intervention par Lamy online

____

► Résumé de l'intervention préparée : Les 4 sessions aborderont les thèmes successifs de confiance, de risque, de transmission et de leadership, auxquels les professionnels de droit sont confrontés, notamment du fait des algorithmiques.

Pour d'une part ne pas traiter en soi ces sujets que d'autres vont traiter et parce que d'autre part, il convient d'aborder la question à partir de ce qu'est le futur.

Le futur a une part de stabilité : à cette stabilité, c'est-à-dire le maintien du passé, le juriste peut contribuer (I).

Le futur a une part de prévisibilité : à cette part, le juriste doit l'accroitre (II).

Le futur a une part de nouveauté radicale : à cette part, qui peut correspondre à un précipice, si personne n'avait imaginé, le juriste peut aussi être là. Or, l'on pense aux juristes plutôt dans les 2 premières hypothèses, moins dans celle-ci (III).

A chacune de ces 3 dimensions, les juristes, en tant qu'ils forment une communauté qui doit demeurer soudée autour de l'idée même du droit (les algorithmes ne conçoivent pas d'idée, ce sont les humains qui les transmettent à d'autres humains, le système algorithmique devant demeurer être un média), doivent être présents.

Dans chacune de ces dimensions, le système algorithmique (AI) est présenté comme remplaçant l'humain ou dominant l'humain.

En ce qui concerne la stabilité de l'avenir, le juriste peut et doit y contribuer notamment par la transmission car il n'y a d'autant moins de page blanche que la "création" algorithmique s'appuie sur les données du passé, la formation, où l'humain va être d'autant plus au centre qu'il faut manier des machines.

En ce qui concerne la prévisibilité de l'avenir, il s'agit d'évaluer les risques, particuliers et systémiques, risques juridiques ou non-juridiques, pour ne pas les prendre ou pour les prendre. Plus le juriste sera associé à la prise de risque et plus il sera à sa place, avant et dans l'action.

En ce qui concerne le radicalement nouveau de l'avenir, il n'est pas aisé de qualifier d'AI comme tel ou non, mais la possible disparition de l'Etat de Droit aux Etats-Unis en est un. L'on attend alors du juriste d'avoir deux vertus (que l'algorithme ne soit pas) : la vertu de justice et la vertu de courage. C'est celles-là que nous devons transmettre et partager.

____

L'actualité m'a conduite à consacrer le temps qui m'était imparti à insister sur une seule perspective, la troisième, pour dire ce que l'on attend des juristes si l'on perçoit du radicalement nouveau dans le futur proche.

En effet, aux Etats-Unis sont associés d'une part un chef de l'Etat pour lequel le Droit n'existe pas et qui utilise le pouvoir de la réglementation pour exprimer son indifférence absolue à l'encontre des Etats, des entreprises, des êtres humains, et d'autre part un entrepreneur qui affirme qu'il va devenir le maître de la technologique algorithmique, système sur lequel il exerce déjà une grande puissance.

Face à cette nouveauté radicale, l'on attend de la communauté des juristes, de tous les juristes, quelle que soit leur place, leur maîtrise technique, leur niveau, leur nationalité, qu'ils s'expriment pour dire Non. Comme l'ont fait Kelsen, Cassin ou Ginsberg. Dire Non et aider les autres à dire Non. Pour cela, ils faut que ces êtres humains que sont les juristes, en tant qu'ils se soucient des autres êtres humains, aient conscience de la double vertu qui est attendue d'eux : la vertu d'attachement à la justice et la vertu de courage.

________

28 janvier 2025

Conférences

🌐suivre Marie-Anne Frison-Roche sur LinkedIn

🌐s'abonner à la Newsletter MAFR. Regulation, Compliance, Law

🌐s'abonner à la Newsletter Surplomb, par MAFR

____

► Référence complète : M.-A. Frison-Roche, "Juger une situation familiale, une "obligation impossible"", in Collège de Droit de l'Université Panthéon-Sorbonne (Paris I), Dialogue avec Éliette Abécassis autour de son roman Divorce à la française, Amphi Turgot, Sorbonne, 28 janvier 2025, 20h-21h30, Paris.

____

🪑🪑🪑Cette conférence a été ouverte par Philippe Stoffel-Munck, co-directeur du Collège de Droit de l'Université Panthéon-Sorbonne (Paris I), qui a présenté les parcours, travaux et personnalités d'Éliette Abécassis et de moi-même.

Puis, selon le principe du dialogue, Éliette Abécassis a présenté trois points d'un point de vue littéraire et philosophique sur lesquels elle m'a demandé d'exprimer ma perspective.

- Le premier point portait sur la procédure, les caractères contradictoires des discours des uns et des autres, la place de la vérité dans une procédure de divorce et la place de la vérité.

- Le deuxième point a porté sur la difficulté de juger, sur l'impossibilité même de juger, son roman étant construit pour mettre le lecteur dans la position qui est celle du juger : comment arriver à juger ?

- Le troisième point a porté sur le caractère "profondément humain" des divorces et du jugement de ceux-ci et, en conséquence, de ce qui donnerait l'application de ladite intelligence artificielle en la matière.

Selon la méthode convenue entre nous, n'ayant pas été prévenue du choix de ces perspectives-là mais connaissant bien Éliette Abécassis et son oeuvre, j'ai donc développé "sur le banc" les points suivants pour les articuler à l'auditoire composé d'étudiants en droit en 1ière, 2ième et 3ième année :

____

► Présentation de mes réponses aux questions ouvertes par Eliette Abécassis dans ce dialogue : 🔴Éliette a montré comment dans Divorce à la français, elle a fait parlé de multiples personnes impliquées dans la procédure de divorce qui font des récits contradictoires, proposant des vérités qui se contredisent, reprenant comme trame du roman la procédure elle-même. Les vérités multiples sont ainsi confrontées, notamment celle de la littérature et celle du Droit.

I. LE PRINCIPE DU CONTRADICTOIRE, LA VÉRITÉ, LES PARTIES ET LE JUGE

La procédure est effectivement gouvernée par le "principe du contradictoire". Pour les parties au litige, il ne s'agit pas particulièrement de participer à la recherche de la vérité : une partie dans un procès veut gagner, c'est-à-dire notamment que son adversaire perde. Le débat et son alimentation notamment en éléments de preuve a pour bénéficiaire principe le juge. D'ailleurs et à ce titre le principe du contradictoire se démarque des droits de la défense, en ce que ceux-ci n'ont pas toujours pour objectif la vérité mais sont des prérogatives, de plus haut niveau dont les personnes sont titulaires parce qu'elles sont en risque dans la perspective de la décision susceptible d'être prise. Elles peuvent ainsi se défendre, par exemple en mentant, ou en se taisant. Les autorités sont donc davantage favorables au contradictoire, principe qui fonctionne en leur faveur, qu'aux droits de la défense, droits subjectifs qui leur sont parfois opposées. Parce que le juge est gardien de l'État de droit, il concrétise le contradictoire mais aussi les droits de la défense. Parce que la vérité peut aussi être un argument, elle peut aussi alimenter défense et débat mais gardons en tête cette opposition de départ qui fonde le Droit processuel, que Divorce à la française illustre.

🔴Le deuxième point est sur la difficulté de juger. Éliette Abécassis souligne la difficulté de juger qui est d'autant plus pointée dans son roman que le juge est à la fois omniprésent qu'il est le seul à ne pas prendre la parole. C'est donc le lecteur qui est institué juge. Il perçoit lui-même à travers son expérience de lecteur la difficulté de juger, mais aussi l'importance de juger. Elle se réfère notamment notamment aux travaux de Paul Ricoeur sur l'enjeu du jugement et du juste.

II. LE DIFFICILE ART DE JUGER, OBLIGATION IMPOSSIBLE

Cela m'a fait penser à l'ouvrage publié avec un ami très cher qui étudia avec moi dans ce même Amphi Turgot la philosophie pour une licence de philosophie, ouvrage ayant pour titre La justice. L'obligation impossible. Il est "impossible" de juger, parce qu'il est "impossible" d'être juste.

Faut-il donc se détourner de cet office-là ? De cette prétention-là ? Non, car si la justice, comme la vérité, est un point que nul ne peut atteindre, alors que la Justice est une vertu qui contient toutes les autres et en cela si nous ne sommes pas justes nous n'avons plus aucune vertu (par exemple la vertu du courage), il convient (comme le fait tout juge) partir des situations.

Les situations sont injustes. Etre juste, c'est d'abord être sensible, être perspicace à l'intensité d'injustice de telle ou telle situation. C'est déjà ça. Puis, c'est agir. C'est-à-dire la dire, ce qui est déjà un premier jugement. Puis la trancher, la réparer, la consoler. C'est ainsi que l'on peut être juste. C'est sans doute pour cela que l'on devient juge. Notamment lorsqu'il s'agit des situations familiales.

🔴Éliette insiste sur la violence des conflits qui s'exprime aussi dans les procédures de divorce et que son roman met en scène. Cette instabilité des rapports humains correspond à une société qui est en train de "liquéfier" les rapports entres les êtres humains, et bientôt les êtres humains eux-mêmes. Elle s'inquiète de ce que va produire sur la justice humaine l'usage de l'intelligence artificielle.

III. LES ALGORITHMES, APPUI OU DESTRUCTION DE L'OFFICE DU JUGE

Le troisième point porte donc sur la pertinence, légitimité et efficacité de l'usage des algorithmes dans les contentieux de divorce. Il est tentant de répondre en bloc que le système algorithmique sans âme ne doit pas toucher ce contentieux-là car pour reprendre les mots d'Eliette Abécassis, il est "profondément humain" et donc seul un juge humain peut y toucher. Mais il faut aussi considérer que la procédure, dont on a montré tout à l'heure la dimension humaniste à travers le contradictoire et les droits de la défense, est une machinerie, avec des délais et des séries d'actes de procédure que des algorithmes aident à mener et à contrôler.

La procédure c'est par nature du temps, et plus exactement de la durée, du temps qui passe. Il faut que la dispute ait le temps de s'apaiser. Faire durer peut aussi l'exacerber. Les outils algorithmiques peuvent permettre aux parties de se libérer, d'en finir. Il ne s'agit pas seulement d'une logique de gestion de flux vue du côté de l'institution mais aussi de justice pour les parties en litige qui peuvent en être libérées grâce à ces outils-là. Temps utile, délai raisonnable, sont aussi des garanties de procédure.

L'enjeu est alors d'avoir du discernement sur deux discernements. En premier lieu en distinguant ce qui relève de l'intendance procédurale que le système algorithmique et ce qui relève du choix qui doit être laissé au juge et aux parties. En second lieu, en distinguant ce qui dans les différents cas est identique malgré la singularité (définition de ce qu'est l'analogie) et se prêtent donc à la puissance algorithmique et qui n'est pas analogue. L'analogie est l'art même du juriste.

_____

1 octobre 2024

MAFR TV : MAFR TV - Surplomb

🌐suivre Marie-Anne Frison-Roche sur LinkedIn

🌐s'abonner à la Newsletter MAFR. Regulation, Compliance, Law

🌐s'abonner à la Newsletter Surplomb, par MAFR

____

► Référence complète : M.-A. Frison-Roche, "Du Droit de la Compliance découle le Droit de l'Intelligence Artificielle", in série de vidéos Surplomb, 1er octobre 2024ré

____

🌐visionner sur LinkedIn cette vidéo de la série Surplomb

____

____

🎬visionner ci-dessous cette vidéo de la série Surplomb⤵️

____

Surplomp, par mafr

la série de vidéos dédiée à la Régulation, la Compliance et la Vigilance

Mise à jour : 15 septembre 2024 (Rédaction initiale : )

droit illustré

► Référence complète : M.-A. Frison-Roche., "🎬𝑰'𝒎 𝒚𝒐𝒖𝒓 𝒎𝒂𝒏 - une question à laquelle réponse est demandée : la loi doit-elle autoriser le mariage avec un robot humanoïde ?", billet 15 septembre 2024.

► voir le film-annonce

___

Ce film allemand de 2021de Maria Schrader a reçu le Lion .. à la Nostra de Venise

Il est une fable sur l'intelligence artificielle dans notre société, maintenant et demain.

Dans une société du futur, d'un futur proche, une entreprise (on ne sait pas laquelle) propose à des humains de tester des robots humanoïdes pendant 3 semaines, comme "compagnon idéal", au terme duquel l'humain fournit un rapport pour formuler une opinion argumentée en répondant à la question suivante : Le législateur doit-il changer la loi pour admettre un mariage entre un humain et l'humanoïde.

La fable se déroule entre une femme, Alma, qui accepte de faire cette expérience. Elle n'est pas rémunérée et ne travaille pas dans l'I.A., elle travaille sur la culture perse et le déchiffrage de l'écriture cunéiforme. Son patron lui indique que si elle accepte l'expérience, des crédits seront sans doute débloqués pour permettre à son équipe de poursuivre ses recherches sur ce sujet-là. Il précise, en riant : "bien sûr, je ne cherche en rien à te corrompre".

Se présente donc le "compagnon idéal" réalisé selon ses goûts. Il a par exemple un accent britannique (elle est universitaire, elle apprécie la distinction d'un accent britannique, etc.)

Pendant 3 semaines, le robot parfait s'adapte, et elle a bien du mal mais trouve petit à petit qu'il est vraiment parfait, elle s'ouvre petit à petit.

Elle a beaucoup de soucis. Vit complètement seule. Son mari vient de la quitter pour une autre. Dont elle apprend qu'elle attend un enfant, tandis qu'elle a perdu un enfant jadis et n'en a jamais eu par la suite. Son père est atteint d'un Alzheimer en stade avancé et elle a bien du mal à l'aider.

Tandis que le robot, Tom, fait tout parfaitement, mais cela ne va jamais vraiment bien, puisqu'il ne sent pas, n'a pas froid, n'a pas faim, n'a pas peur. Il peut tout calculer, c'est commode. Elle se sent seule et veut arrêter car plus elle le voit et plus elle se sent à la fois seule et attirer par ce compagnon idéal qui lui appartient : I'm your man.

C'est vrai, c'est tentant.

A aucun moment, on ne voit ni ne parle de l'entreprise qui fabrique les algorithmes et les robots, qui sont manifestement au stade expérimental.

Elle rencontre dans la rue un homme qu'elle avait rencontré précédemment : il est juriste et tient à son bras une jeune fille, souriante, jolie, qui le regarde avec affection. Il lui dit : vous en êtes où ? Moi, j'ai été sollicité parce que je suis juriste. Pour donner une opinion juridique. Mais je suis si heureux ! Avant personne ne voulait de moi. Peut-être pour une histoire de pheromones ou pour mon physique (il est un peu gros) ou parce que j'ai 62 ans. Et maintenant je suis si heureux avec elle ! Je suis en train de négocier pour la garder toujours ! Je crois que je vais arriver à obtenir cela !"

Alma rend son rapport qui tient en quelques lignes : il est le compagnon parfait, qui peut pallier notre solitude, s'ajuster à nos désirs, répondre à tout. Mais notre condition humain est d'avoir des désirs qui ne sont pas comblés, d'avoir des questions sans réponse, d'aller de l'avant. Avec de tels robots, l'humain n'ira plus de l'avant. Il ne faut exclure totalement la possibilité de mariage entre des humains et des algorithmes à forme humaine.

____

On peut mettre ce film dans la longue liste des films qui prennent ce thème essentiel.

Le film prophétique de Spielberg , Intelligence Artificiel où le robot joué par Jude Law est prostitué, où le robot principal est l'enfant tant désiré.

Le film Her où l'amour pour la suite algorithmique dont l'humain est amoureux choisit de s'ajuster plutôt à un autre algorithme.

____

Prenons cela du côté du Droit

1. La question est celle du Législateur. La réponse est claire : c'est Non.

2. L'industrie est invisible : que peut le Législateur à l'égard d'une industrie que l'on ne voit pas, que l'on entend pas, qui n'écrit pas, dont les représentants ne sont eux-mêmes que des androïdes ?

3. La question expressément posée portait aussi sur l'éthique. Après, l'on n'a plus aucune discussion et aucune réponse : quand on n'a pas d'interlocuteur, il est difficile de formuler.

4. Le lien entre les savants et l'industrie est clairement posé ; il n'est pas choquant en soi

5. Le juriste, sollicité sur la dimension juridique, est celui qui l'aborde le mieux, celui qui veut garder la "jeune fille idéale", celui qui ne se pose aucune question éthique.

Juridiquement, c'est donc une très triste fable.

____

28 juin 2024

Base Documentaire : Soft Law

► Référence complète : Autorité de la concurrence (ADLC), avis 24-A-05 du 28 juin 2024 relatif au fonctionnement concurrentiel du secteur de l’intelligence artificielle générative, juin 2024, 104 p.

____

____

📰lire le communiqué de presse accompagnant la publication de l'avis

________

28 juin 2024

Base Documentaire : Doctrine

► Référence complète : E. Netter, "Quand la force de conviction du scoring bancaire provoque sa chute. L'interprétation extensive, par la CJUE, de la prohibition des décisions entièrement automatisées", RTD com., 2024, chron., pp.342-348

____

🦉Cet article est accessible en texte intégral pour les personnes inscrites aux enseignements de la Professeure Marie-Anne Frison-Roche

________

24 juin 2024

Organisation de manifestations scientifiques

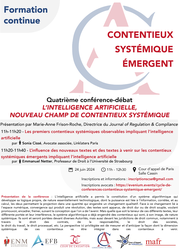

► Référence complète : L’intelligence artificielle, nouveau champ de contentieux systémique, in cycle de conférences-débats "Contentieux Systémique Émergent", organisé à l'initiative de la Cour d'appel de Paris, avec la Cour de cassation, la Cour d'appel de Versailles, l'École nationale de la magistrature (ENM) et l'École de formation des barreaux du ressort de la Cour d'appel de Paris (EFB), sous la responsabilité scientifique de Marie-Anne Frison-Roche, 24 juin 2024, 11h-12h30, Cour d'appel de Paris, salle Cassin

____

🌐consulter sur LinkedIn le compte-rendu de cette manifestation

____

► Présentation de la conférence : L'intelligence artificielle a permis la constitution d'un système algorithmique. Celui-ci développe une logique qui lui est propre, de nature essentiellement technologique. Elle engendre une puissance de calcul basée sur la mise en corrélation des informations pour fabriquer des possibles causalités et construire des probabilités que l'on assimile parfois à des "prédictions", la masse traitée finissant par engendrer un changement qualitatif.

Ce changement est lié à l'espace numérique, lequel par nature fait émerger un contentieux systémique, auquel a été consacré la conférence-débat du 27 mai 2024.

Le contentieux systémique est concerné de trois façons, qu'il s'agit ici d'anticiper car les contentieux sont pour l'instant naissants ou à venir mais vont sans doute advenir brutalement.

En premier lieu, il est possible que l'outil technologique permette de traiter certains dossiers dont la technicité, soit des notions soit des demandes, ou la multitude des demandes si simples soient-elles, requièrent cette aptitude à traiter la masse, ce qui engendre la montée en puissance à la fois de cette puissance mécanique algorithmique et la présence plus grande des êtres humains, notamment par l'accroissement de l'accusatoire, de la mise en état, des médiations, etc.

En deuxième lieu, , Face à ce changement lié à l'espace numérique, des "textes" sont apparus pour "réguler" l'usage ou l'invention même de tel ou tel outil algorithmique, textes de nature très diverses, de plus souple ou plus dur (cette variation entre droit souple et droit dur est le thème repris dans la conférence-débat du 19 septembre 2024). Il peut s'agir de dispositifs pris par les entreprises qui produisent les outils, par celles qui les utilisent, par celles qui les diffusent, les personnes concernées par les informations étant relativement actives. Ce dernier point expliquent que des contentieux systémiques sont déjà en cours et portent sur les droits subjectifs qui seraient violés soit par nature du fait de l'intelligence artificielle, en l'espèce les droits des créateurs, ou les droits à la vie privée, ou d'autres Buts Monumentaux. La dimension systémique, notamment extraterritoriale de ces contentieux, est déjà acquise.

Le troisième point est la part du Politique, puisque l'Union Européenne par les textes en cours d'adoption a posé que le But n'est pas seulement la durabilité du système technique, le marché de l'innovation, la souveraineté européenne, mais aussi la primauté des personnes, à travers une méthode qui est la hiérarchisation Ex Ante des risques. Cette conception assumée est aussi contestée. Cette question méthodologique se pose aussi au juge.

Ces contentieux systémiques émergents sont et seront portées devant diverses Autorités, de régulation ou de supervision, mais aussi devant les juridictions de droit commun, notamment à travers le droit des contrats, de la responsabilité, le droit des sociétés, le droit du travail, le droit processuel, etc.

La perspective ici privilégiée est de mesurer et d'anticiper la façon dont la dimension systémique de ces contentieux va être intégrer dans ces contentieux à venir.

____

🧮Programme de cette manifestation :

Quatrième conférence-débat

L’INTELLIGENCE ARTIFICIELLE, NOUVEAU CHAMP DE CONTENTIEUX SYSTÉMIQUE

Cour d’appel de Paris, salle Cassin

Présentation et modération par 🕴️Marie-Anne Frison-Roche, Professeure de Droit de la Régulation et de la Compliance, Directrice du Journal of Regulation & Compliance (JoRC)

🕰️11h-11h10. 🎤Les deux rencontres entre l'intelligence artificielle et le Contentieux Systémique, par 🕴️Marie-Anne Frison-Roche, Professeure de Droit de la Régulation et de la Compliance, Directrice du Journal of Regulation & Compliance (JoRC)

🕰️11h10-11h30. 🎤Les premiers contentieux systémiques observables impliquant l’intelligence artificielle, par 🕴️Sonia Cissé, Avocate Associée, Linklaters Paris

🕰️11h30-11h50. 🎤L’influence des nouveaux textes et des textes à venir sur les contentieux systémiques émergents impliquant l’intelligence artificielle, par 🕴️Emmanuel Netter, Professeur de Droit à l'Université de Strasbourg

🕰️11h50-12h30. Débat

____

🔴Les inscriptions et renseignements se font à l’adresse : inscriptionscse@gmail.com

🔴Pour les avocats, les inscriptions se font à l’adresse suivante : https://evenium.events/cycle-de-conferences-contentieux-systemique-emergent/

⚠️Les conférences-débat se tiennent en présentiel à la Cour d’appel de Paris.

____

🧮Lire ci-dessous la présentation détaillée de la manifestation faite par Marie-Anne Frison-Roche⤵️

24 juin 2024

Conférences

► Référence complète : M.-A. Frison-Roche, "Les deux rencontres entre l'intelligence artificielle et le Contentieux Systémique", in L’intelligence artificielle, nouveau champ de contentieux systémique, in cycle de conférences-débats "Contentieux Systémique Émergent", organisé à l'initiative de la Cour d'appel de Paris, avec la Cour de cassation, la Cour d'appel de Versailles, l'École nationale de la magistrature (ENM) et l'École de formation des barreaux du ressort de la Cour d'appel de Paris (EFB), sous la responsabilité scientifique de Marie-Anne Frison-Roche, 24 juin 2024, 11h-12h30, Cour d'appel de Paris, salle Cassin

____

🧮consulter le programme complet de cette manifestation

____

► Résumé de la conférence : Dans la présentation générale sur le thème lui-même, j'ai souligné "Les deux rencontres entre l'intelligence artificielle et le Contentieux Systémique".

La perspective retenue dans la conférence n'est pas l'état de ce qui est convenu d'appeler l'"Intelligence Artificielle", mais bien la façon dont on doit corréler ici l'IA et le "Contentieux Systémique Émergent" (CSE).

Cela suppose de rappeler ce qu'est un "contentieux systémique" (1), puis de voir l'apport de l'intelligence artificielle pour traiter ce type de contentieux (2), avant de voir que le système algorithmique lui-même peut être l'objet de Contentieux Systémique (3).

1. Ce qu'est le Contentieux Systémique que l'on voit Émerger

Sur la notion même de "Contentieux Systémique Émergent", proposée en 2021, lire : M.-A. Frison-Roche, 🚧L'hypothèse de la catégorie des causes systémiques portés devant le juge, 2021.

Ce Contentieux Systémique Émergent vise des situations dont la connaissance est portée devant le juge et dans lesquelles un système est impliqué. Il peut s'agir du système bancaire, du système financier, du système énergétique, du système numérique, du système climatique, du système algorithmique.

Dans ce type de contentieux, les intérêts et l'avenir du système lui-même sont "en cause". Le juge doit donc les "prendre en considération"📎

En cela, le "Contentieux Systémique" doit se distinguer du "contentieux de masse". Le "contentieux de masse" vise des litiges très nombreux et analogues. Le fait qu'ils soient souvent de "faible importance" n'est pas forcément déterminant, car ces litiges sont importants pour les personnes en cause (cf. l'article déterminant de Carbonnier, "De Minimis...", 1981)📎

2. L'apport de la puissance algorithmique dans la menée d'un Contentieux Systémique

À ce titre, l'IA peut être un outil utile, voire indispensable, pour maîtriser de tels Contentieux Systémiques, dont l'émergence correspond à une nouveauté et dont la connaissance est portée devant le juge de droit commun.

En effet, ce type de contentieux est particulièrement complexe et long, les questions probatoires étant au centre, les expertises succédant aux expertises. L'appréciation des expertises est difficile à mener. L'IA peut alors être un moyen pour le juge, afin de juguler de risque accru de capture par les experts de son devoir de décision, de maîtriser la dimension expertale du Contentieux Systémique.

Le choix des techniques d'IA présente les mêmes difficultés que celles exposées depuis toujours à propos des experts. Il est probable que des mécanismes de certification, analogues à l'inscription sur des listes d'experts, se mettent en place, si l'on s'écarte de la construction par les juridictions elles-mêmes (ou par le gouvernement, ce qui peut poser un problème d'indépendance de la justice), ou si l'on veut un contrôle sur des outils fournis par les parties elles-mêmes, au regard du principe de l'égalité des armes, en raison du coût de ces outils.

3. Lorsque c'est le système algorithmique lui-même qui est l'objet d'un Contentieux Systémique : sa place est alors plutôt en défense

En outre et d'une façon centrale, le système algorithmique donne lui-même lieu à un Contentieux Systémique, en ce que des personnes peuvent saisir le Juge en prétendant avoir subi un dommage par le fonctionnement du système algorithmique ou en demandant l'exécution d'un contrat rédigé par ce système. C'est sur le terrain du Droit commun des obligations que le système peut se trouver impliqué dans l'instance juridictionnelle.

Il est remarquable que, par rapport à des hypothèses jusqu'ici privilégiées dans les précédentes conférences-débats, notamment le 26 avril 2024 à propos du Contentieux Systémique Émergent lié au Devoir de Vigilance📎

Or, l'instance change si le système est présenté non plus comme la "victime" potentielle mais plutôt comme le "coupable" potentiel. Il est notamment beaucoup moins clair d'identifier quel type d'intervenant dans l'instance, qui ne soit pas nécessairement partie au litige, a vocation à parler pour expliciter l'intérêt du système, notamment au regard de la durabilité et de l'avenir du système de l'IA.

Ce point de réflexion devra être approfondi par les chefs de juridiction.

________

🕴️Fr. Ancel, 📝Quel rôle pour le juge aujourd’hui dans la compliance ? Quel office processuel du juge dans la compliance ?, in 🏛️Conseil d'État et 🏛️Cour de cassation, 📗De la régulation à la compliance : quel rôle pour le juge ?, 2024.

🕴️J. Carbonnier, 📝De minimis..., in 📗Mélanges dédiés à Jean Vincent, 1981.

🧮La vigilance, nouveau champ de contentieux systémique, in cycle de conférences-débats "Contentieux Systémique Émergent", organisé à l'initiative de la Cour d'appel de Paris, avec la Cour de cassation, la Cour d'appel de Versailles, l'École nationale de la magistrature (ENM) et l'École de formation des barreaux du ressort de la Cour d'appel de Paris (EFB), sous la responsabilité scientifique de Marie-Anne Frison-Roche, 26 avril 2024.

13 juin 2024

Base Documentaire : 06.1. Textes de l'Union Européenne

► Référence complète : Règlement (UE) 2024/1689 du Parlement européen et du Conseil du 13 juin 2024 établissant des règles harmonisées concernant l’intelligence artificielle et modifiant les règlements (CE) n° 300/2008, (UE) n° 167/2013, (UE) n° 168/2013, (UE) 2018/858, (UE) 2018/1139 et (UE) 2019/2144 et les directives 2014/90/UE, (UE) 2016/797 et (UE) 2020/1828 (règlement sur l’intelligence artificielle) (en anglais Artificial Intelligence Act, dit "IA Act")

____

________

3 juin 2024

Base Documentaire : Convention, contrat, composition, engagement

► Référence complète : N. Yax, H. Anlio & S. Palminteri, "Studying and improving reasoning in humans and machines", Communications Psychology volume 2, Article number: 51 (2024)

____

30 mai 2024

Base Documentaire : Doctrine

► Référence complète : Th. Douville, "De l'approche extensive de la prise de décision exclusivement automatisée (à propos du refus d'un prêt fondé sur une note de solvabilité communiquée par un tiers)", D. 2024, pp. 1000-1004

____

🦉Cet article est accessible en texte intégral pour les personnes inscrites aux enseignements de la Professeure Marie-Anne Frison-Roche

________

27 mai 2024

Organisation de manifestations scientifiques

► Référence complète : Les contrôles techniques des risques présents sur les plateformes et les contentieux engendrés, in cycle de conférences-débats "Contentieux Systémique Émergent", organisé à l'initiative de la Cour d'appel de Paris, avec la Cour de cassation, la Cour d'appel de Versailles, l'École nationale de la magistrature (ENM) et l'École de formation des barreaux du ressort de la Cour d'appel de Paris (EFB), sous la responsabilité scientifique de Marie-Anne Frison-Roche, 27 mai 2024, 9h-10h30, Cour d'appel de Paris, salle Cassin

____

🧮consulter le programme complet du cycle Contentieux Systémique Émergent

____

🌐consulter sur LinkedIn le compte-rendu de cette manifestation

____

🧱lire ci-dessous le compte-rendu de cette manifestation⤵️

____

► Présentation de la conférence : L'espace numérique est un espace de risques. Certains y sont naturellement associés, parce qu'il s'agit d'un espace de libertés, d'autres doivent être contrés parce qu'ils sont associés à des comportements interdits d'une façon générale, par exemple le blanchiment d'argent. Mais l'espace numérique a développé des risques qui, par leur ampleur ont été transformés dans leur nature même : il en est ainsi notamment de la déformation imprégnant certains contenus et de l'insécurité qui peut menacer l'ensemble du système lui-même. Le Droit a alors confié aux opérateurs eux-mêmes la vigilance sur ce qui sont devenus des "cyber-risques", comme le risque de désinformation, le risque de destruction des infrastructures de communication, le risque de vol de données, perspective systémique qui peut faire s'effondrer les sociétés elles-mêmes.

De nouveaux textes sont élaborées, notamment le Digital Services Act, pour à la fois accroître les charges et les pouvoirs des entreprises en la matière, les entreprises numériques étant en première ligne, mais aussi les autorités de supervision, comme l'Arcom. Les contentieux qui en naissent, dans lesquels entreprises et régulateurs peuvent être alliés ou en opposition, sont par nature systémiques.

Le traitement par le juge de ces "causes systémiques", par la procédure et les solutions, doit répondre à cette dimension systémique. Le cas dit des "sites pornographiques", qui est en train de se dérouler, permet d'observer in vivo le dialogue des juges lorsqu'une "cause systémique" s'impose à eux.

____

🧮Programme de cette manifestation :

Troisième conférence-débat

LES CONTROLES TECHNIQUES DES RISQUES PRESENTS SUR LES PLATEFORMES ET LES CONTENTIEUX ENGENDRES

Cour d’appel de Paris, salle Cassin

modération par 🕴️Marie-Anne Frison-Roche, Professeure de Droit de la Régulation et de la Compliance, Directrice du Journal of Regulation & Compliance (JoRC)

🕰️9h-9h10. 🎤Le contentieux Systémique Emergent du fait du système numérique, 🕴️Marie-Anne Frison-Roche

🕰️9h10-9h30. 🎤Les techniques de gestion du risque systémique pesant sur la cybersécurité des plateformes, 🕴️Michel Séjean, Professeur de droit à l'Université Sorbonne Paris Nord

🕰️9h30-9h50. 🎤Un système systémique in vivo : le cas dit des sites pornographiques,🕴️Marie-Anne Frison-Roche

🕰️9h50-10h10. 🎤Les obligations systémiques des opérateurs numériques à travers le Règlement sur les Services Numériques (RSN/DSA) et le rôle des régulateurs, par 🕴️Roch-Olivier Maistre, Président de l’Autorité de régulation de la communication audiovisuelle et numérique (Arcom)

🕰️10h10-10h30. Débat

____

🔴Les inscriptions et renseignements se font à l’adresse : inscriptionscse@gmail.com

🔴Pour les avocats, les inscriptions se font à l’adresse suivante : https://evenium.events/cycle-de-conferences-contentieux-systemique-emergent/

⚠️Les conférences-débat se tiennent en présentiel à la Cour d’appel de Paris.

________

22 mai 2024

Base Documentaire : Doctrine

► Référence complète : M. Mueller, The Myth of AGI. How the illusion of Artificial General Intelligence distorts and distracts digital governance, Internet Governance Project (IGP) White Paper, n°11, mai 2024, 20 p.

____

► Résumé de l'article (fait par l'auteur) : "The claim that Artificial General Intelligence (AGI) poses a risk of human extinction is largely responsible for the urgency surrounding AI governance. This paper reviews and critically evaluates the AGI-related literature in computer science, economics and philosophy to understand the assumptions and logic underlying claims that AI can threaten human survival. The review identifies three inter-related fallacies underlying AGI doomer scenarios: a) the idea that a machine can have a “general intelligence;” b) anthropomorphism, or the attribution of autonomous goals, desires and self-preservation motives to human-built machines; and c) the assumption that the superior calculating intelligence of an AGI will give it unlimited power over physical resources and social institutions. The paper characterizes these assumptions as unrealistic and exposes the lack of logic and empirical evidence in the doomer scenarios. Evaluating the AGI construct is important from a public policy perspective because of the myth's enormous influence on the way governments, industry and the public approach digital governance. The idea of an all-powerful autonomous AGI misdirects policy interventions toward precautionary regulation of the design or production of all AI applications, while diverting our attention from more mundane, yet realistic risks posed by specific AI uses and users. The myth of existential risk also encourages governments to attempt to assert control over the entire digital ecosystem in ways that stifle competition and innovation and centralize power.".

____

🦉Cet article est accessible en texte intégral pour les personnes inscrites aux enseignements de la Professeure Marie-Anne Frison-Roche

________

15 avril 2024

Base Documentaire : Doctrine

► Référence complète : Commission de l'intelligence artificielle, présidée par Ph. Aghion et A. Bouverot, IA : notre ambition pour la France, Rapport remis au Premier ministre, mars 2024, 130 p.

____

________

17 janvier 2024

Base Documentaire : Doctrine

► Référence complète : U. Goldberg, "Collecte et traitement des informations dans les enquêtes internes à l'ère numérique : processus et enjeux", in M.-A. Frison-Roche et M. Boissavy (dir.), Compliance et droits de la défense. Enquête interne – CJIP – CRPC, Journal of Regulation & Compliance (JoRC) et Dalloz, coll. "Régulations & Compliance" à paraître.

____

📕consulter une présentation générale de l'ouvrage, Compliance et droits de la défense - Enquête interne, CIIP, CRPC, dans lequel cet article est publié

____

► Résumé de l'article (fait par le Journal of Regulation & Compliance - JoRC) : L'objet de l'article est de décrire la technologie de l'enquête interne. C'est pourquoi la question des droits de la défense n'y est pas abordée en tant que telle mais plutôt la méthodologie requise par l'objet recherché, le traitement des informations requis pour l'atteindre et les contraintes engendrées par les outils utilisés. Il s'agit en effet d'obtenir une fiabilité et une efficience la plus grande possible dans la collecte des données et le maniement de celles-ci.

L'auteur expose les méthodes pour obtenir les données. Cela est rendu difficile par la variété des systèmes juridiques simultanément applicables, par les obligations de confidentialité et le caractère personnel de certaines données, ce qui les rend juridiquement inexploitables. Il convient ensuite d'extraire dans la masse des données celles qui seront pertinentes.

La méthodologie utilisée par le professionnel consiste à indiquer clairement au départ le périmètre de la recherche d'informations et les spécificités de l'enquête, cadre à communiquer aux personnes et organisations impliquées. Plus précisément, il faut préciser l'étendue géographique de la recherche, la période couverte, les personnes impliquées dans l'enquête interne, le type de données recherchées, les systèmes informatiques impliqués, le niveau de confidentialité imposé, les procédures internes liées à la conservation des données et à leur accès. Les informations collectées sont soit structurées, soit non structurées, les deux types s'articulant, et la technologie évoluant sans cesse, tandis que les principes de l'enquête doivent demeurer stables.

____

🦉Cet article est accessible en texte intégral pour les personnes inscrites aux enseignements de la Professeure Marie-Anne Frison-Roche

________